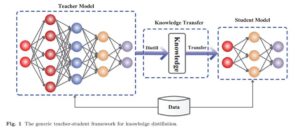

知識蒸留(Knowledge Distillation)は、ディープラーニングにおいて、教師モデルの知識を生徒モデルに転送する手法です。

この手法は、大規模な教師モデルの性能を小規模な生徒モデルに伝達することで、計算リソースやメモリ使用量を削減し、リアルタイム性やデバイスへの適合性を向上させることができます。

特にエッジAIなど、デバイス制限下での運用が想定される場合に大いに役立ちます。

基礎モデル(Foundation Model)

基礎モデルは、スタンフォード大学のHAI(人工知能研究所)によって広められた用語であり、膨大なデータセットに基づいてトレーニングされたモデルを意味します。これらのモデルは、自然言語処理や画像認識などのタスクにおいて、高い精度を示すことがあります。

有名なものとして、自然言語処理では、OpenAIが開発したGPTシリーズやGoogleが開発したBERTなどがあげられます。画像認識では、 IDEAが開発したGroundingDINOやMetaが開発したSAM(Segment Anything)などがあげられます。

基礎モデルが普及した背景には、いくつかの要因が寄与しています。まず第一に、巨大なデータセットの利用が挙げられます。これらのモデルは、数十億ものテキストや画像から学習し、その膨大な知識を利用して様々なタスクを解決します。また、計算資源の向上も大きな役割を果たしています。近年、高性能なGPUやTPU(Tensor Processing Unit)の普及により、これらの大規模なモデルを効率的にトレーニングすることが可能になりました。さらにGPTなどTransformerベースアーキテクチャにおいてデータセットをスケーリングすることで大幅な精度向上が観測できたという成功体験から、大規模データセットの利用が加速しています。

知識蒸留の手法

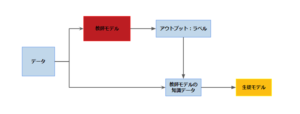

知識蒸留の具体的な手法にはいくつかありますが、今回は教師モデルのアウトプットを生徒モデルのインプットとするシンプルな手法を紹介したいと思います。

また、このとき教師モデルとして基礎モデルが使用されます。

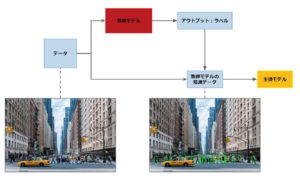

コンピュータビジョンにおける物体検出タスクでは、例えば人の検出を考えます。

まず、オリジナルの画像が教師モデルの入力とされ、その検出結果がラベルとして得られます。

次に、得られたラベルとオリジナルの画像を組み合わせてアノテーションされたデータセットを準備します。

最後に、このデータセットを使用して生徒モデルのトレーニングを行います。

・データ: オリジナル画像

・教師モデルの知識データ: アノテーションされた画像(トレーニングデータセット)

この手法のメリットは、データ(つまり画像)が実質的に触媒の役割を果たすため、マニュアル作業がデータ収集に限定されることです。

さらに、本番環境に近いデータだけでなく、あらゆる種類のデータを組み込むことが可能です。そのため、従来のアノテーション作業なしに、より汎用性の高いモデルを構築する可能性が高まります。

さらに、異なるトレーニングデータセットを使用して教師モデルと生徒モデルを同時に学習しその過程でlogits lossを減らすようにする手法や、複数の教師モデルを組み合わせて蒸留する手法など、様々な手法が存在します。

実際のトレーニングでは、これらの手法のメリットとデメリットを見極め、うまく活用することが重要です。

まとめ

知識蒸留は、ディープラーニングにおける教師モデルの知識を生徒モデルに転送する手法です。

この手法は、計算リソースやメモリ使用量を削減し、リアルタイム性やデバイスへの適合性を向上させることができます。

基礎モデルは、膨大なデータセットに基づいてトレーニングされたモデルであり、自然言語処理や画像認識などのタスクにおいて高い精度を示します。

知識蒸留の手法として、教師モデルのアウトプットを生徒モデルのインプットとするシンプルな手法があります。

データが実質的に触媒の役割を果たすため、マニュアル作業がデータ収集に限定されることがメリットとして挙げられます。

これにより、従来のアノテーション作業なしに、より汎用性の高いモデルを構築する可能性が高まります。

Avintonでは、ITエンジニアリングトレーニングとチームメンバーの継続的な教育に特に重点を置いています。この分野でのスキルの活用、最先端のテクノロジーへの取り組み、国際的なクライアントへのソリューション提供に興味がある場合は、採用情報のページをご覧ください。ご連絡をお待ちしております!