この記事ではKubernetesとKubeflowを前提とした技術が登場するため、先に機械学習基盤としてのKubernetesを一読することをおすすめします。

機械学習の発展により、モデルの精度を向上させるための重要な技術の1つとして、ハイパーパラメーターチューニングが注目を集めています。ハイパーパラメーターチューニングは、モデルのパフォーマンスを最適化するために、ハイパーパラメーターの最適な値を見つけるプロセスです。これはしばしば試行錯誤が必要であり、手動で行うと時間がかかるため、自動化が求められています。

Kubeflowは、機械学習ワークフローを管理するためのオープンソースプラットフォームであり、その一部としてKatibという自動ハイパーパラメーターチューニングツールが提供されています。そこで今回は、Katibの概要と機能、そしてその利点について簡単に紹介したいと思います。

Katibの概要

Kubeflowのコンポーネントの一つとして提供されるKatibは、機械学習モデルのハイパーパラメーターチューニングを効率化し、自動化するための強力なツールです。

その豊富な機能と利点により、研究者やデータサイエンティストはモデルのパフォーマンスを向上させるための新たな手法を探求できます。

Katibの活用により、機械学習の進化を促進し、新たな可能性を開拓することが期待されます。

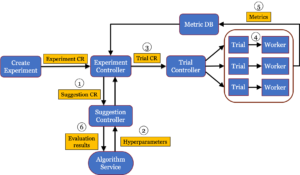

Katibがハイパーパラメータチューングを行う際のダイアグラム

このダイアグラムを理解するには、Kubernetesに関する深い理解が必要ですが、完全な理解はここでは不要です。

単に、Kubernetesが複雑な制御を提供し、それがユーザーに便利であることを理解していただければ十分です。

参照:https://blog.kubeflow.org/katib/

一方で、Kubernetesの長所を活かし、複数ノードにまたがってパラレルにジョブポッドを走らせることができる点は、重要な特徴です。

計算リソースを効率的に活用することで、ハイパーパラメータ探索の並列化が容易になり、探索時間の短縮や複数のハイパーパラメータ設定の同時評価が実現されます。さらに、Kubernetesのスケーラビリティと柔軟性により、必要に応じてリソースの動的な割り当てや管理が行えるため、探索プロセスの調整や追加リソースの割り当てが容易に行えます。

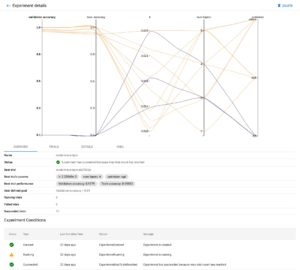

Kubeflow Experiment(Katib) UI

ハイパーパラメータチューニングは、”探索”と表現されることが多いです。その理由は、モデルトレーニング前にあらかじめ設定される値でありその最適解がわからないためです。

そのため、探索アルゴリズムを使用して、ハイパーパラメータの空間を効率的に探索し、最適な組み合わせを見つける必要があります。

Katib(Kubeflow UI)では”探索”によって得られたメトリクスから、ユーザが分析しやすいようにパラレルコーディネートグラフがサポートされています。このグラフを分析することで、異なるハイパーパラメータの組み合わせがモデルの性能にどのように影響するかを直感的に理解することができます。さらに、ハイパーパラメータの空間を視覚化することで、探索プロセスの進行状況を把握し、より効果的なチューニング手法を採用することができます。

参照:https://www.kubeflow.org/docs/components/katib/overview/#hyperparameters-and-hyperparameter-tuning

サーチアルゴリズム

Katibは、ハイパーパラメータの探索に様々なアルゴリズムを提供しています。これらのアルゴリズムは、異なるアプローチを取り、ユーザーが目標に合わせて最適な探索戦略を選択できるようになっています。以下は代表的なアルゴリズムの簡単な紹介です。

・グリッドサーチ(Grid Search): あらかじめ指定されたハイパーパラメータの値の組み合わせを全て試す方法です。例えば、ハイパーパラメータAには[0.1, 0.2, 0.3]、ハイパーパラメータBには[1, 2, 3]といった具合に値を指定し、全ての組み合わせを網羅的に試します。この方法は比較的シンプルで理解しやすく、ハイパーパラメータ空間が小さい場合に有効です。

・ランダムサーチ(Random Search): あらかじめ指定された範囲からハイパーパラメータの組み合わせをランダムに選択して試す方法です。グリッドサーチと異なり、全ての可能な組み合わせを試す必要がなく、ランダムに選択されたサンプルを用いて探索を行います。

・ベイズ最適化 (Bayesian Optimization): 過去の試行結果から得られた情報を用いて、次の試行ポイントを選択する方法です。非線形な目的関数やハイパーパラメータ空間が大きい場合に特に有効です。

より詳細な説明やその他のアルゴリズムについて知りたい場合は公式ドキュメントを参照して下さい。

Metrics Collector

KatibのMetrics Collectorは、その名の通り、モデルのトレーニング中に得られるメトリクスを収集する機能を指します。この機能は非常に柔軟で、ユーザーがさまざまな方法でメトリクスを収集できます。例えば、任意のログファイルや標準出力から、正規表現を使用してメトリクスを抽出することができます。これにより、ユーザーは自分のニーズに合わせてカスタマイズでき、特定のメトリクスをトラッキングし、モデルのトレーニングの進行状況を監視することができます。

さらに、Metrics Collectorはリアルタイムでメトリクスを収集し、それらを視覚化することができるため、ユーザーはトレーニングの進捗状況をリアルタイムで把握できます。これにより、モデルのパフォーマンスを迅速に評価し、必要に応じてトレーニングを調整することができます。また、収集されたメトリクスは後で分析やレポート作成に使用することもできます。

余談ですが、Metrics Collectorはワーカーポッドのサイドカーコンテナとして動作します。そのため、任意のログファイルを追跡する場合はPersistent Volumeを通じて共有される必要がありますが、チューニング(Experiment)実行時に正しく設定すれば自動でそれらが定義されます。こうしたサポートもKatibの強みです。

まとめ

本記事では、ハイパーパラメーターチューニングの重要性とその自動化ツールであるKatibについて簡単に解説しました。

Katibは、機械学習モデルの開発における多くのメリットを提供します。その最大のメリットの一つは、ハイパーパラメータの探索を自動化し、試行錯誤から解放することです。手動でのハイパーパラメータの調整は時間とリソースを消費しますが、Katibを使用することで、効率的かつ効果的に最適なハイパーパラメータを見つけることができます。さらに、Katibは豊富な探索アルゴリズムを提供し、ユーザーが目標に合わせて最適な探索戦略を選択できます。これにより、異なる問題やデータセットに対して最適なモデルを見つけるための柔軟性が高まります。また、KatibはKubernetesの柔軟性とスケーラビリティを活かして、複数ノードにまたがってパラレルにジョブポッドを走らせることができます。これにより、計算リソースを効率的に活用し、ハイパーパラメータの探索時間を短縮することができます。さらに、KatibのMetrics Collectorを使用することで、リアルタイムでメトリクスを収集し、モデルのトレーニングの進行状況を監視することができます。これにより、ユーザーは迅速にモデルのパフォーマンスを評価し、必要に応じてトレーニングを調整することができます。

Avintonでは、ITエンジニアリングトレーニングとチームメンバーの継続的な教育に特に重点を置いています。この分野でのスキルの活用、最先端のテクノロジーへの取り組み、国際的なクライアントへのソリューション提供に興味がある場合は、採用情報のページをご覧ください。ご連絡をお待ちしております!