EC2からS3へ自動でぽいぽいアップロードするスクリプトの作成

- ルーティング

- データベースの命名規則

- 三目並べ – 2.〇×を交互にゲーム盤に入るようにしよう

- 三目並べ – 3.勝敗がつくようにしよう

- クリーンコード(Clean Code)

- 三目並べ – 4.「スタート」「リセット」ボタンをつけよう

- 三目並べ – 5.先攻後攻を決めて、コンピュータ対戦にしよう(前編)

- インフラストラクチャー(サーバー、コンポーネント、RAID)

- 機械学習入門者向け Support Vector Machine (SVM) に触れてみる

- YOLOv8を用いた物体検出

- 正規表現とパイプ

- 機械学習エンジニアに必要なスキル

- 軽量版Kubernetesディストリビューション – k0s クラスターの構築

- ファイル操作コマンド

- グループとユーザー

- 困った時に使うコマンド

- 一般グループのユーザーとグループ

- プライバシーポリシー

- 三目並べ – 6.先攻後攻を決めて、コンピュータ対戦にしよう(後編)

- フロントエンド開発のための環境構築

- ファイル検索コマンド

- 質問

- 仮想化環境のディスク容量を拡張する

- ユーザー権限とアクセス権

- データ分析基礎 – Part1

- 三目並べ – 0.導入

- テキスト処理

- データベースへのデータロード

- 機械学習概要1

- 機械学習入門者向け Naive Bayes(単純ベイズ)アルゴリズムに触れてみる

- ファイル管理

- SSHを使用してホストOSからゲストOSに接続する

- 機械学習入門者向け ChainerRLでブロック崩しの学習

- 機械学習入門者向け ランダムフォレストによる Kaggle Titanic生存者予測

- 機械学習概要2

- データ分析基礎 – Part 2

- 機械学習入門者向け 分類と回帰の違いをプログラムを書いて学ぼう

- フロントエンドのWeb開発について

- ダイナミックルーティング

- 三目並べ – 1.ゲーム盤を作ろう

- 【Python入門】Python Numpy チュートリアル

- Amazon EC2 インスタンスの初期設定をしよう

- AmazonEC2とVPCでネットワークとサーバーを構築しよう

- Apache NiFi Exercise

- Apache NiFi データパイプライン基礎

- Apache NiFiの環境設定

- Apache Spark 基礎

- Apache SparkとApache Zeppelinの概要と環境構築

- Apache Superset maptoolの使い方

- Apache Superset 基礎

- Apache Superset 概要と環境構築

- Apache Zeppelin 基本機能

- APIのデモンストレーション

- Avinton Academy コンテンツガイド

- AWS CLIをインストールしてコマンド操作しよう

- AWS CLIを使ってEC2のファイルをS3へアップロードしよう

- AWS Route 53を使って独自ドメインのWebページを表示させてみよう

- AWSアカウントの作成と必ずやるべきセキュリティ対策

- AWSのEC2インスタンスでWordPressブログを公開してみよう

- AWS入門者向け 初心者が最初に理解すべきEC2とVPCの基本的な用語解説

- CCNA

- Certbotを使ってSSL証明書を発行し、HTTP通信を暗号化しよう

- CISCO 1800ルータセットアップ

- CSV import & export – Node.js, mySQL – 1

- CSV import & export – Node.js, mySQL – 2

- Docker Compose(Nginx + Flask + MySQL)演習

- Docker Engineのubuntu上へのinstall

- Docker 概要とセットアップ

- Docker, Kubernetesの学び方について

- Dockerコンテナイメージの最適化/ベストプラクティス

- DockerとApacheを使ってWebサーバーを構築しよう

- EC2からS3へ自動でぽいぽいアップロードするスクリプトの作成

- ESP32-CAMのサンプルアプリケーションを実行する

- 01 – Sparkfun Inventor’s Kit の準備

- 02 – Sparkfun Inventor’s KitでLチカ

- 03 ポテンショメータでLEDの点滅間隔をアナログ入力する

- 04 フォトレジスタで明るさに反応するシステムをつくる

- 05 LCDに文字列を表示する

- 06 – BME280とLCDを組み合わせて温度計をつくる

- ESP32とArduino IDE/PlatfromIOでHello Worldアプリケーションの実行

- ESP32と超音波センサー HC-SR04 で物体の距離を計測する

- ESXi – Switchの追加とVLAN

- ESXi – VyOS

- ESXi – 小規模ネットワーク 構築

- Gitとは

- VS CodeでGitHub Copilotを設定する

- VSCode リモート開発環境

- GNS3のセットアップ

- Kubernetesクラスター上へのOpenVINOモデルサーバーを使用したサンプルアプリケーションのデプロイ

- Linuxとは

- NAT

- NodeJSでWebアプリケーション開発 – React編

- NodeJSでWebアプリケーション開発 – React編

- NodeJSでWebアプリケーション開発 – React編

- NodeJSでWebアプリケーション開発 – Socket.IO編

- NVIDIA Cumulus VX + GNS3でBGPネットワークのシミュレーション

- OpenCVのテストプログラム

- PacketTracerのセットアップ

- Pandasによる構造化データ分析

- PCからルータ、スイッチへのSSH接続設定

- PostGIS exercise

- PostgreSQL – Python – Apache – Bootstrap

- MySQLとMySQL Workbench のセットアップ

- PostgreSQL Setup

- PostgreSQL – インデックスを利用したパフォーマンス改善方法

- PostgreSQL – パーティショニングを利用したパフォーマンス改善方法

- PostgreSQLによるデータ分析

- postgreSQLへのshp fileのimport

- Python2.7とOpenCVのインストール

- Python3.8 と OpenCV のインストール (Ubuntu20.04LTS)

- Pythonでデータベースを操作する

- Pythonで画像を分類するプログラムを作成する

- Pythonによるマルチスレッドプログラミング実践

- Raspberry Pi 4B のセットアップ

- Raspberry PiとBME280を使用して温度と湿度、気圧を読み取る

- REDIS

- Redux基礎 – 主要な概念と用語

- Ruby on Rails を MySQLでセットアップ

- Ruby on Railsによる簡単なウェブアプリケーション

- SampleアプリケーションのKubernetes上へのデプロイ

- Scala 基礎

- scikit-learnとは

- Spark SQL エクササイズ

- SparkMLによるKaggle Titanic生存者予測

- KNIME, AutoMLライブラリによる住宅価格予測

- SparkMLによる住宅価格予測

- SQL 便利な関数

- Ubuntuの基本設定

- uhubctlでUSBデバイスのオンオフをコントロール

- Terraform入門 2 – Terraformのstate管理

- Terraform入門 1 – TerraformでAWS上にEC2インスタンスを作成する

- Virtualisation and Container (仮想化とコンテナ) – Ansible, Docker and Kubernetes

- viエディタ

- VLAN

- VMware ESXi サーバー構築

- Webアプリ開発に欠かせないGoogle Chrome DevToolsの基本

- Windows Server 2012 R2 Hyper-V

- Object Detection with YOLOv8

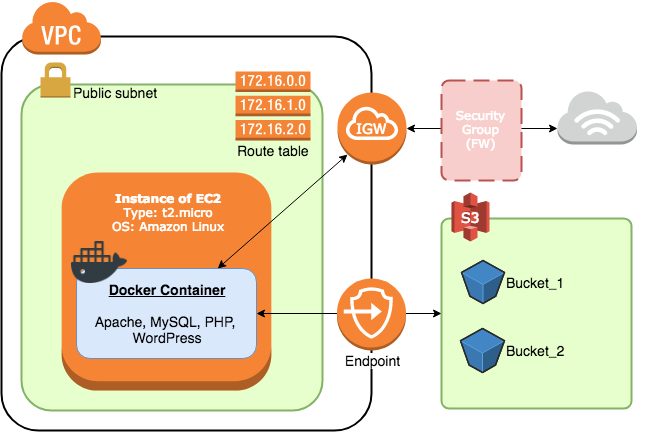

これまでAWS、Dockerなど、様々なサービスを利用してWebサーバーを整備してきました。

今回はそのWebサーバー(コンテナ)を、丸ごとS3へバックアップするシステムを作成しましょう。

万が一に備えてバックアップを取ることは、サービスを維持するためにとても重要です。

しかしバックアップ作業に時間を取られ、コンテンツの作成など本来時間を費やすべき作業がおろそかになるのは避けたいですよね。

そこでAWS CLIとシェルスクリプト、Crontabを組み合わせ、全てのバックアップ作業の完全自動化を目指します。

DockerのコンテナをS3へアップロードするシェルスクリプト

まず、コンテナをS3へアップロードするスクリプトを作成しましょう。

EC2インスタンスへSSHし、 container-backup.sh という名前でファイルを作成してください。

|

1 2 3 |

ssh -i ~/.ssh/HOGEHOGE -p xxxxx YOUR_PUBLIC_IP sudo su - touch container-backup.sh |

~

docker ps コマンドを実行し、 NAMES (コンテナの名前)をメモします。

![]()

そして次のスクリプトの YOUR_CONTAINER_NAME と YOUR_S3_BUCKET_NAME の箇所を自分の環境に合わせて変更し、 container-backup.sh へコピペします。

- YOUR_CONTAINER_NAME …先ほどメモしたコンテナの名前

- YOUR_S3_BUCKET_NAME …AWS S3のバケット名

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 |

#/bin/bash container_name="YOUR_CONTAINER_NAME" #あなたの環境に合わせて変更 container_id=`docker ps -aqf name={container_name}` container_detail="my_container" bucket_name="YOUR_S3_BUCKET_NAME" #あなたの環境に合わせて変更 directory_name="container-backup" #check variables echo ${container_id} echo ${container_detail} #docker export docker export ${container_id} > /tmp/${container_detail}.tar #upload docker image to S3-bucket /usr/bin/aws s3 rm s3://hodalab-backup/container-backup/ --recursive --include "${container_detail}-*" /usr/bin/aws s3 cp /tmp/${container_detail}.tar s3://${bucket_name}/${directory_name}/${container_detail}-`date "+%Y%m%d"`.tar |

~

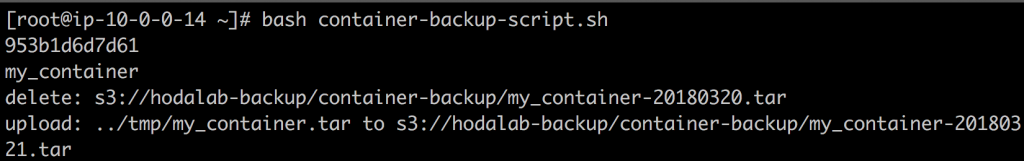

準備ができたら作成したシェルスクリプトを実行しましょう。

|

1 |

bash container-backup.sh |

スクリプトを実行すると、S3にコンテナがアップロードされます。

シェルスクリプトの説明

このシェルスクリプトでは次の操作が順に行われています。

1. 必要な情報を変数へ格納

2. Dockerコンテナのエクスポート

3. S3バケットの中身の削除とコンテナのアップロード

それぞれ詳しく見ていきましょう。

1. 必要な情報を変数へ格納

↓この部分で必要なデータを変数へ格納しています。

|

1 2 3 4 5 6 |

container_name="YOUR_CONTAINER_NAME" #環境に合わせて変更変更 container_id=`docker ps -aqf name={container_name}` container_detail="my_container" bucket_name="YOUR_S3_BUCKET_NAME" #環境に合わせて変更変更 directory_name="container-backup" |

~

- container_name…バックアップ対象のコンテナの名前

- container_id…バックアップ対象のコンテナのID

- container_detail…コンテナのファイル名に使用

- bucket_name…アップロード先のS3バケット名

- directory_name…アップロード先のS3バケット配下のディレクトリ名

2. Dockerコンテナのエクスポート

Dockerは docker export コマンドを使うことで、コンテナを丸ごとパッケージングし、tarファイルとして出力することができます。

パッケージングされたコンテナは複製や移動が簡単にできるため、バックアップやデプロイに最適です。

↓この箇所では、変数へ格納したコンテナのIDを引数に取り、/tmp/ディレクトリ配下へ出力しています。

|

1 |

docker export {container_id} > /tmp/${container_detail}.tar |

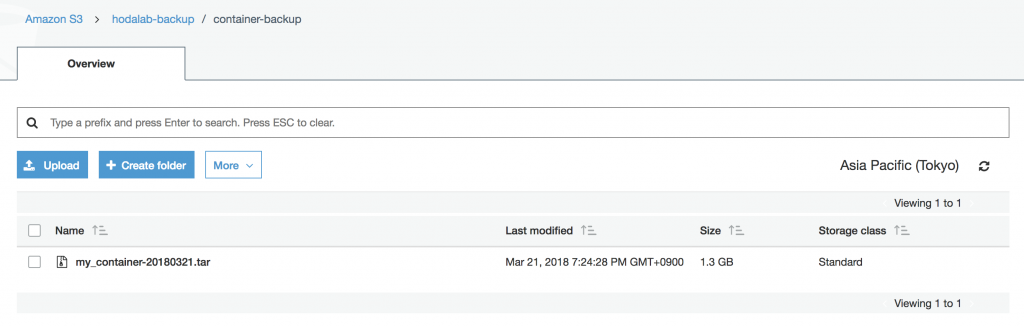

3. S3バケットの中身の削除とコンテナのアップロード

最後の2行で、S3バケットの中身を一旦削除した後、コンテナファイルをアップロードしています。

|

1 2 |

/usr/bin/aws s3 rm s3://hodalab-backup/container-backup/ --recursive --include "{container_detail}-*" /usr/bin/aws s3 cp /tmp/${container_detail}.tar s3://${bucket_name}/${directory_name}/${container_detail}-`date "+%Y%m%d"`.tar |

~

S3にて、無料利用できるストレージ枠は5GBと少なく、無尽蔵に保存するわけにはいきません。

そのため、すでに保存されているコンテナを削除してからアップロードを行なっています。

Crontabによる自動化

AWS CLIとシェルスクリプトを組み合わせ、コンテナのバックアップがとても簡単になりました。

しかしバックアップするたびにインスタンスへSSHしてスクリプトを実行する必要があるため、運用としてはあまりイケてないです。

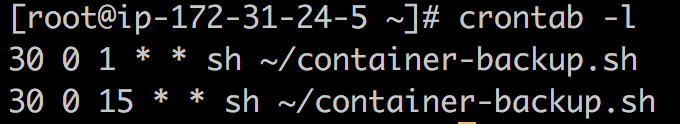

そこで、Crontabを使って完全に自動化しましょう。

Crontab (Cron table) とは

CrontabはCronジョブのスケジュールを記述するためのファイルです。

Cronジョブは、特定の指示(コマンド)を計画的に実行するための設定です。

「この日時でこのコマンドを実行しなさい」というジョブをCrontabに記述することで、時が来たら自動でそのジョブを起動してくれます。

Crontabの作成

Crontabは次のコマンドで作成・編集できます。

|

1 |

crontab -e |

Crontabの構文

Crontabはスケジュールを決める5つのフィールドと、実行したいコマンドを指定する1つのフィールドで構成します。

x x x x x command

min hour day month year command

Crontabの設定

それでは実際にCrontabを設定しましょう。

次のコマンドでcrontabファイルを開いてください。

|

1 |

crontab -e |

そして次の内容を記述し、保存します。

|

1 2 |

30 0 1 * * bash ~/container-backup.sh 30 0 15 * * bash ~/container-backup.sh |

~

これで毎月1日と15日の0時30分に、「bash ~/container-backup.sh」コマンドが実行されます。

また、Crontabに記載されているジョブは次のコマンドで確認できます。

|

1 |

crontab -l |

Cronジョブが実際に起動するか心配であれば、直近の日時に変更して試してみると良いでしょう。

演習

S3へバックアップしたコンテナをあなたのPCにダウンロードし、 docker import コマンドで復元(レストア)してみてください。EC2インスタンスで構築した環境が、そのままあなたのPCで再現できることを確認しましょう。

まとめ

AWS CLIとシェルスクリプト、そしてCrontabを使い、コンテナを自動でバックアップできるようになりました。

このコンテンツで紹介したシェルスクリプトはコマンドを並べただけのシンプルなプログラムですが、Crontabなどと組み合わせて自動化すると非常に強力です。

次回

>>AWS Route 53を使って独自ドメインのWebページを表示させてみよう

あなたも、Avintonでこのような最先端技術を習得し活用してみませんか?

社員の成長を導きながら、AIやビッグデータなどの最先端技術をプロジェクトに活用していくことが私たちのビジョンです。Avintonの充実した技術研修でスキルアップを図り、あなたのキャリア目標を一緒に達成しませんか?