AWS CLIを使ってEC2のファイルをS3へアップロードしよう

- ルーティング

- データベースの命名規則

- 三目並べ – 2.〇×を交互にゲーム盤に入るようにしよう

- 三目並べ – 3.勝敗がつくようにしよう

- クリーンコード(Clean Code)

- 三目並べ – 4.「スタート」「リセット」ボタンをつけよう

- 三目並べ – 5.先攻後攻を決めて、コンピュータ対戦にしよう(前編)

- インフラストラクチャー(サーバー、コンポーネント、RAID)

- 機械学習入門者向け Support Vector Machine (SVM) に触れてみる

- YOLOv8を用いた物体検出

- 正規表現とパイプ

- 機械学習エンジニアに必要なスキル

- 軽量版Kubernetesディストリビューション – k0s クラスターの構築

- ファイル操作コマンド

- グループとユーザー

- 困った時に使うコマンド

- 一般グループのユーザーとグループ

- プライバシーポリシー

- 三目並べ – 6.先攻後攻を決めて、コンピュータ対戦にしよう(後編)

- フロントエンド開発のための環境構築

- ファイル検索コマンド

- 質問

- 仮想化環境のディスク容量を拡張する

- ユーザー権限とアクセス権

- データ分析基礎 – Part1

- 三目並べ – 0.導入

- テキスト処理

- データベースへのデータロード

- 機械学習概要1

- 機械学習入門者向け Naive Bayes(単純ベイズ)アルゴリズムに触れてみる

- ファイル管理

- SSHを使用してホストOSからゲストOSに接続する

- 機械学習入門者向け ChainerRLでブロック崩しの学習

- 機械学習入門者向け ランダムフォレストによる Kaggle Titanic生存者予測

- 機械学習概要2

- データ分析基礎 – Part 2

- 機械学習入門者向け 分類と回帰の違いをプログラムを書いて学ぼう

- フロントエンドのWeb開発について

- ダイナミックルーティング

- 三目並べ – 1.ゲーム盤を作ろう

- 【Python入門】Python Numpy チュートリアル

- Amazon EC2 インスタンスの初期設定をしよう

- AmazonEC2とVPCでネットワークとサーバーを構築しよう

- Apache NiFi Exercise

- Apache NiFi データパイプライン基礎

- Apache NiFiの環境設定

- Apache Spark 基礎

- Apache SparkとApache Zeppelinの概要と環境構築

- Apache Superset maptoolの使い方

- Apache Superset 基礎

- Apache Superset 概要と環境構築

- Apache Zeppelin 基本機能

- APIのデモンストレーション

- Avinton Academy コンテンツガイド

- AWS CLIをインストールしてコマンド操作しよう

- AWS CLIを使ってEC2のファイルをS3へアップロードしよう

- AWS Route 53を使って独自ドメインのWebページを表示させてみよう

- AWSアカウントの作成と必ずやるべきセキュリティ対策

- AWSのEC2インスタンスでWordPressブログを公開してみよう

- AWS入門者向け 初心者が最初に理解すべきEC2とVPCの基本的な用語解説

- CCNA

- Certbotを使ってSSL証明書を発行し、HTTP通信を暗号化しよう

- CISCO 1800ルータセットアップ

- CSV import & export – Node.js, mySQL – 1

- CSV import & export – Node.js, mySQL – 2

- Docker Compose(Nginx + Flask + MySQL)演習

- Docker Engineのubuntu上へのinstall

- Docker 概要とセットアップ

- Docker, Kubernetesの学び方について

- Dockerコンテナイメージの最適化/ベストプラクティス

- DockerとApacheを使ってWebサーバーを構築しよう

- EC2からS3へ自動でぽいぽいアップロードするスクリプトの作成

- ESP32-CAMのサンプルアプリケーションを実行する

- 01 – Sparkfun Inventor’s Kit の準備

- 02 – Sparkfun Inventor’s KitでLチカ

- 03 ポテンショメータでLEDの点滅間隔をアナログ入力する

- 04 フォトレジスタで明るさに反応するシステムをつくる

- 05 LCDに文字列を表示する

- 06 – BME280とLCDを組み合わせて温度計をつくる

- ESP32とArduino IDE/PlatfromIOでHello Worldアプリケーションの実行

- ESP32と超音波センサー HC-SR04 で物体の距離を計測する

- ESXi – Switchの追加とVLAN

- ESXi – VyOS

- ESXi – 小規模ネットワーク 構築

- Gitとは

- VS CodeでGitHub Copilotを設定する

- VSCode リモート開発環境

- GNS3のセットアップ

- Kubernetesクラスター上へのOpenVINOモデルサーバーを使用したサンプルアプリケーションのデプロイ

- Linuxとは

- NAT

- NodeJSでWebアプリケーション開発 – React編

- NodeJSでWebアプリケーション開発 – React編

- NodeJSでWebアプリケーション開発 – React編

- NodeJSでWebアプリケーション開発 – Socket.IO編

- NVIDIA Cumulus VX + GNS3でBGPネットワークのシミュレーション

- OpenCVのテストプログラム

- PacketTracerのセットアップ

- Pandasによる構造化データ分析

- PCからルータ、スイッチへのSSH接続設定

- PostGIS exercise

- PostgreSQL – Python – Apache – Bootstrap

- MySQLとMySQL Workbench のセットアップ

- PostgreSQL Setup

- PostgreSQL – インデックスを利用したパフォーマンス改善方法

- PostgreSQL – パーティショニングを利用したパフォーマンス改善方法

- PostgreSQLによるデータ分析

- postgreSQLへのshp fileのimport

- Python2.7とOpenCVのインストール

- Python3.8 と OpenCV のインストール (Ubuntu20.04LTS)

- Pythonでデータベースを操作する

- Pythonで画像を分類するプログラムを作成する

- Pythonによるマルチスレッドプログラミング実践

- Raspberry Pi 4B のセットアップ

- Raspberry PiとBME280を使用して温度と湿度、気圧を読み取る

- REDIS

- Redux基礎 – 主要な概念と用語

- Ruby on Rails を MySQLでセットアップ

- Ruby on Railsによる簡単なウェブアプリケーション

- SampleアプリケーションのKubernetes上へのデプロイ

- Scala 基礎

- scikit-learnとは

- Spark SQL エクササイズ

- SparkMLによるKaggle Titanic生存者予測

- KNIME, AutoMLライブラリによる住宅価格予測

- SparkMLによる住宅価格予測

- SQL 便利な関数

- Ubuntuの基本設定

- uhubctlでUSBデバイスのオンオフをコントロール

- Terraform入門 2 – Terraformのstate管理

- Terraform入門 1 – TerraformでAWS上にEC2インスタンスを作成する

- Virtualisation and Container (仮想化とコンテナ) – Ansible, Docker and Kubernetes

- viエディタ

- VLAN

- VMware ESXi サーバー構築

- Webアプリ開発に欠かせないGoogle Chrome DevToolsの基本

- Windows Server 2012 R2 Hyper-V

- Object Detection with YOLOv8

Amazon S3はAWSにおけるオンラインのストレージサービスです。

Google DriveやDropboxのようなツールをイメージすると分かりやすいでしょう。

今回はS3のバケットの作成とAWS CLIを使ってファイルのアップロードを試してみましょう。

S3の特徴

2018年3月現在、S3は無料枠が5GBに制限されており、他のストレージサービスと比較すると少し割高に感じられます。

しかしAWSサービスとの連携が容易で、AWS CLIを組み合わせて自動化すればスマートな管理ができます。

加えて 99.999999999% という高い耐久性を維持しており、どこからでも安全にデータを保管できる強力なストレージです。

主な使い方としては次ケースが挙げられます。

1.サイズが大きいメディアファイル、EC2やサーバーで記録したログや分析データの保管

2.データのバックアップストレージとしての利用

3.静的なWebサイトやメディアコンテンツの配信

1.サイズが大きいメディアファイルの配信、EC2やサーバーで記録したログや分析データの保管

メディアファイルはサイズが大きいため、メインのサーバーと分けることでサーバーの容量不足対策となります。また、 回線が高速なのでコンテンツの配信に向いています。 WordPressで公開する記事内の画像ファイルなどをS3に保管することで、メインサーバーの負荷を減らしつつ高速にコンテンツを提供できます。

ログは長期間記録すると無視できない大きさになることが稀にありますし、サーバーへ入らずにS3からログをダウンロードできれば、 誤ったコマンド操作で貴重なファイルを削除するリスクも無くせます。

2.データのバックアップストレージとしての利用

Google Driveと同様に、 ファイルのバックアップや共有 目的に利用できます。

3.静的なWebサイトやメディアコンテンツの配信

GitHub pages や GitLab pages のように、 静的なWebサービスの公開に利用できます。

HTML/CSS, JavaScriptなどの静的なプログラミング言語のみで作成されたWebページであれば、EC2よりも低コストで運営が可能です。

さらに独自ドメインやSSL証明書の割り当てができ、S3だけで静的なWebサイトの全てをこなすことができます。

S3のバケット作成

それではさっそくS3を利用しましょう。

S3ではバケットと呼ばれるオブジェクト(ディレクトリのようなもの)を作成し、その中にファイルを保管します。

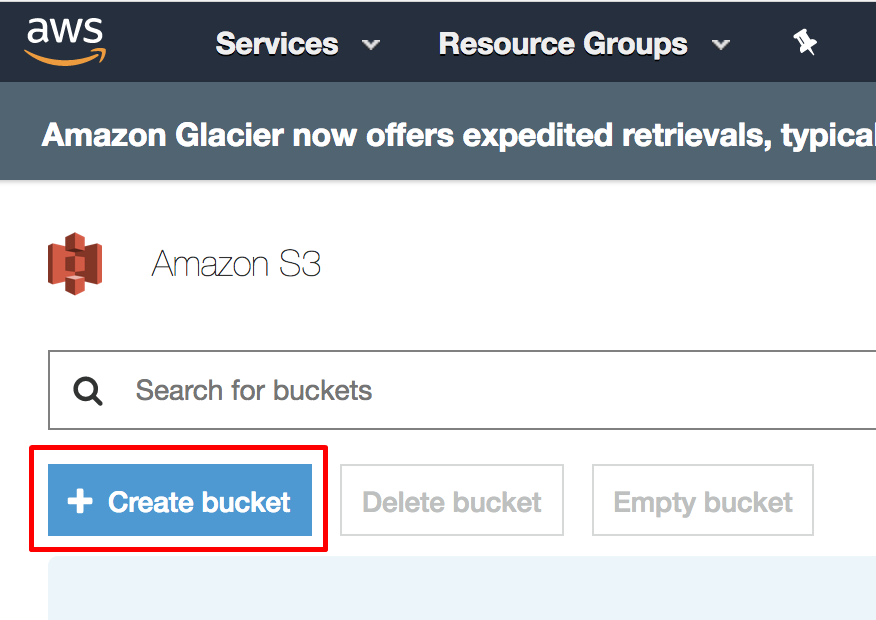

1.S3のダッシュボードを開き、バケットの作成をクリックします。

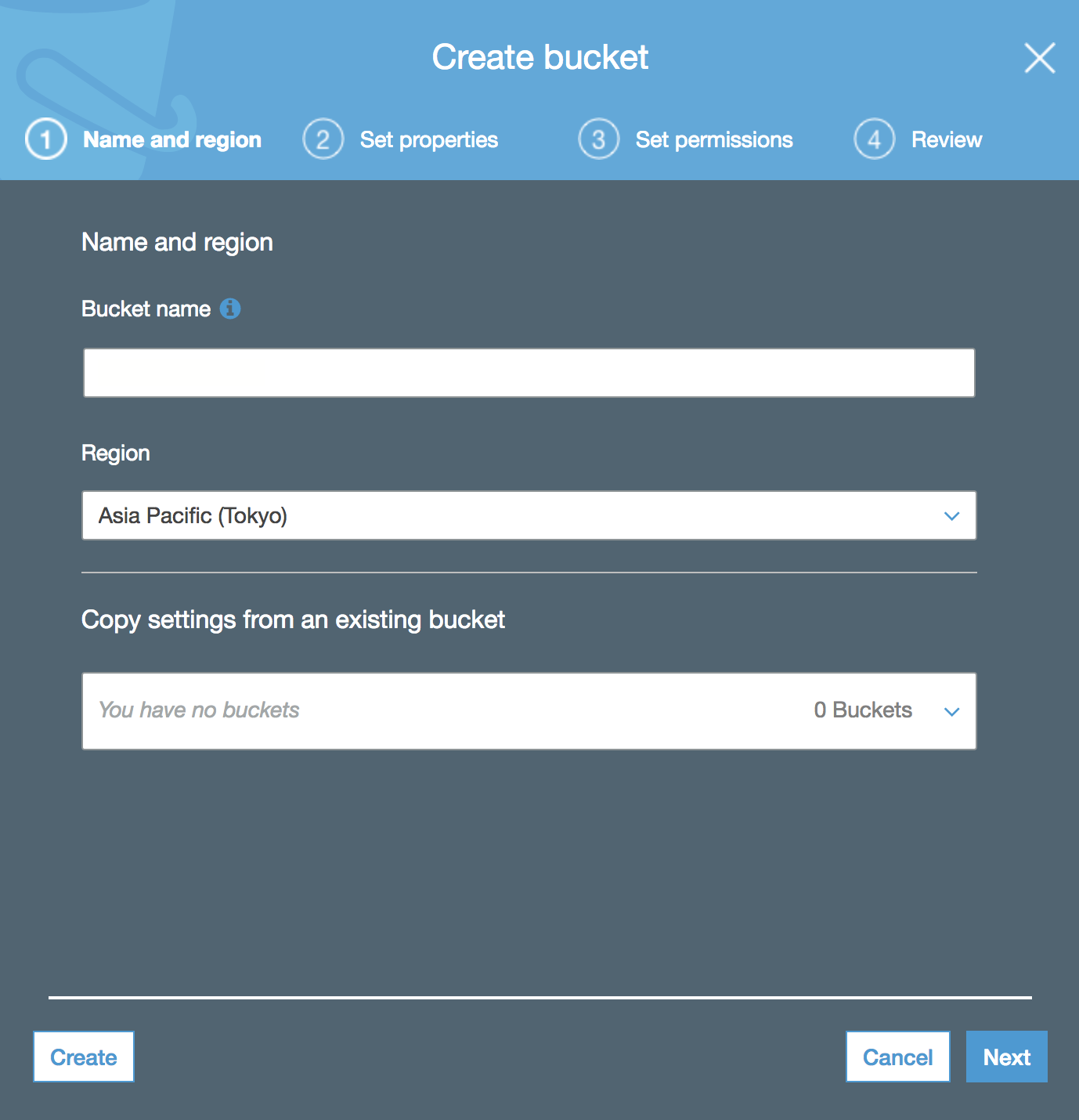

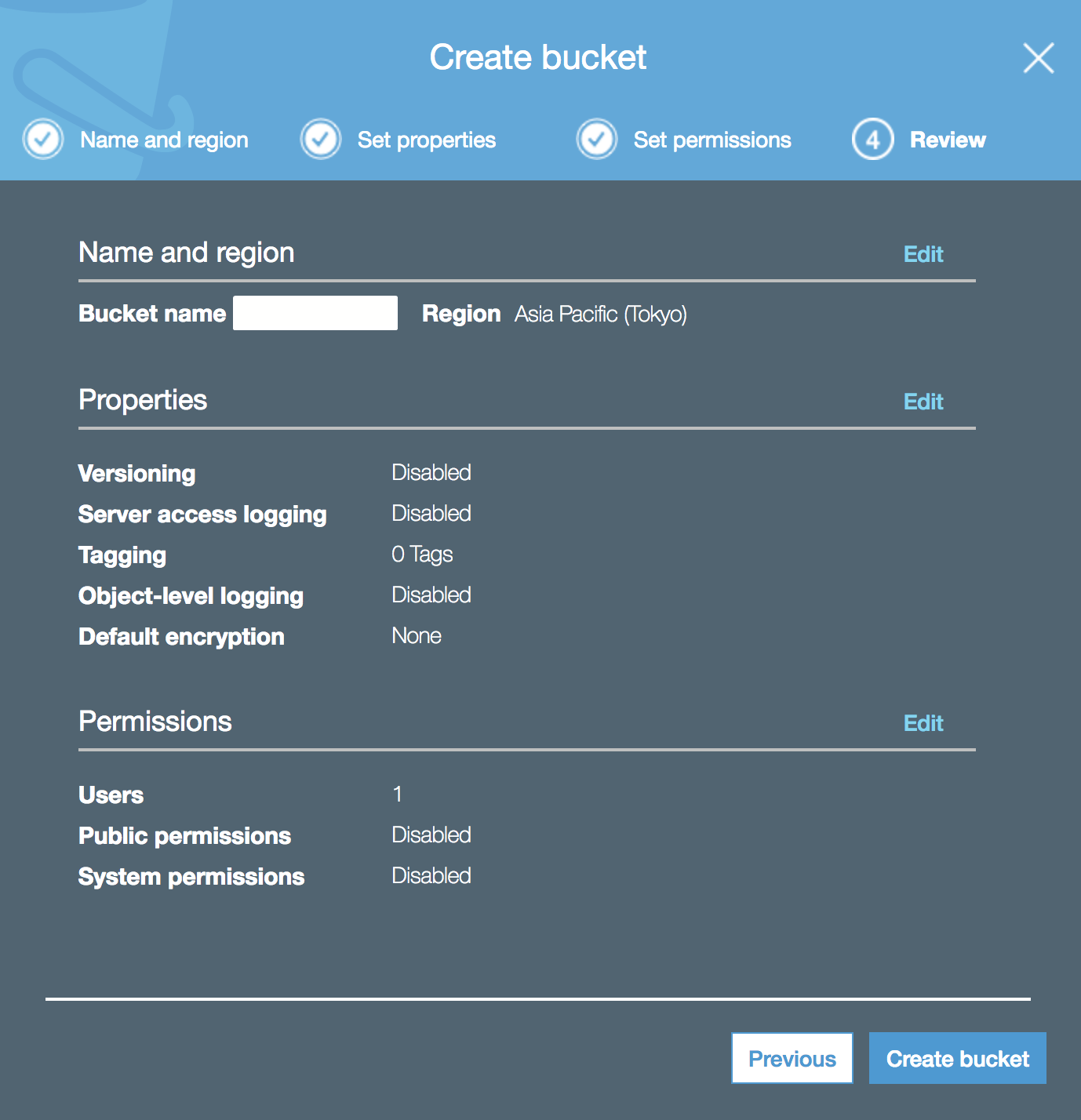

2.バケットの名前とリージョンを設定します。EC2とS3を連携させたいため、EC2インスタンスが置かれているリージョンを選んでください。既存のバケットがあればその設定を引き継ぐことができますが、今回は初めてなので空欄のまま次へ進みます。

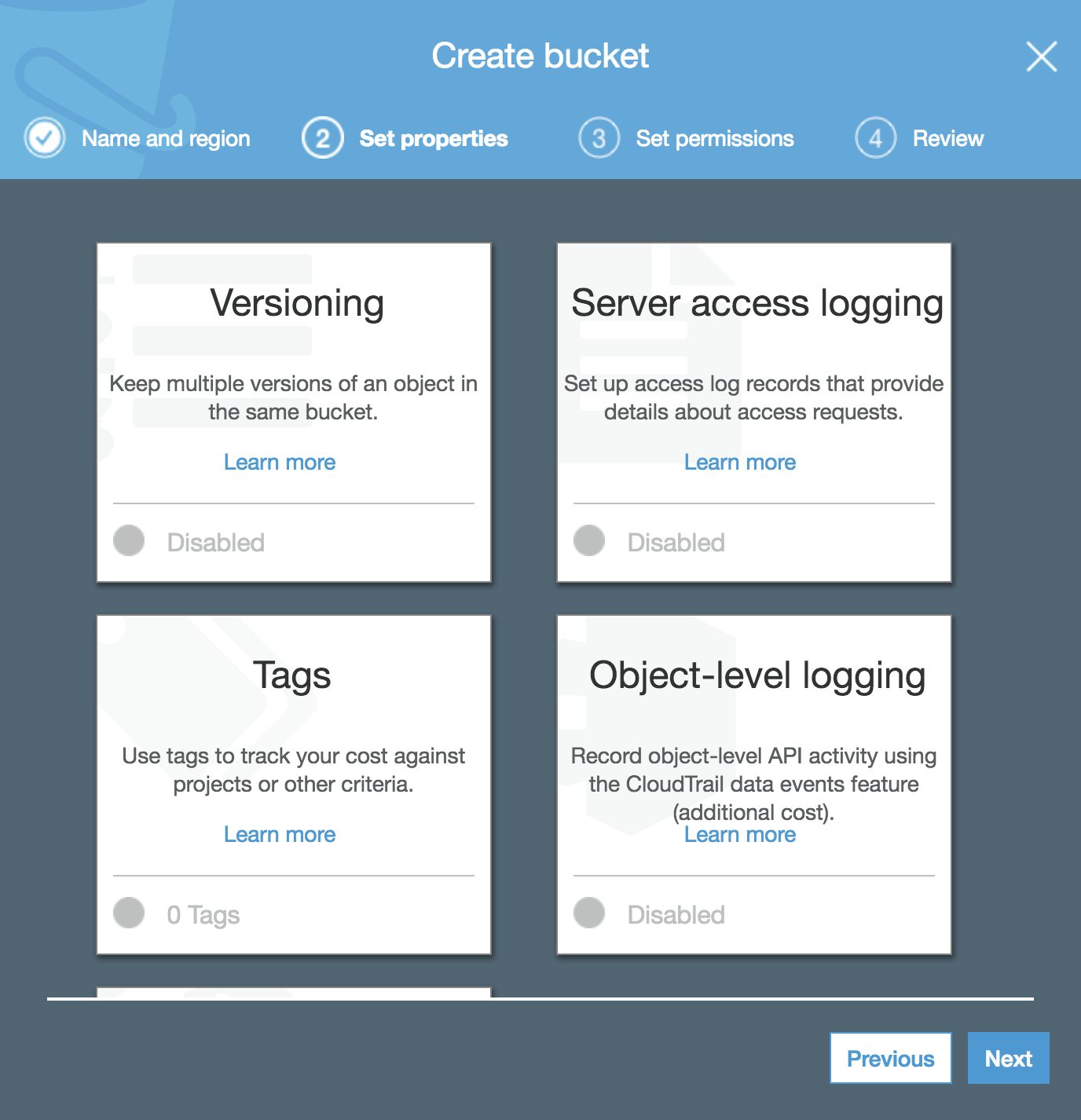

3.バケットのプロパティを設定します。通信の暗号化やバージョン管理を有効にするなど、便利なプロパティがあるので必要に応じて適用します。この設定は後から追加することができるため、何もせずに次へ進んでも大丈夫です。

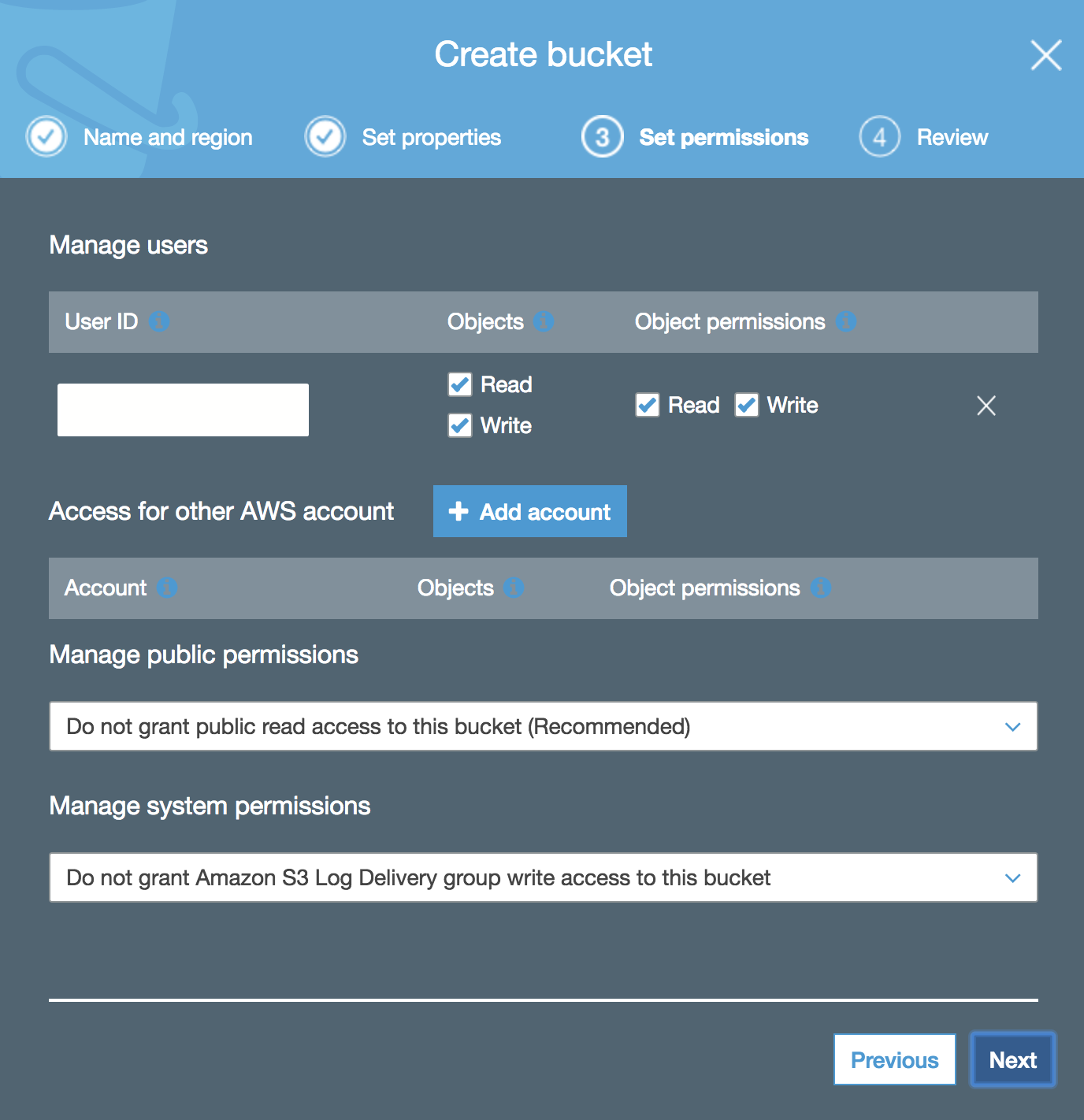

4.パーミッションの設定をします。読み込みと書き込みの許可をアカウントごとに設定することができます。また、今回はバックアップ目的での利用のため、 バケットの公開をしないよう設定してください。

5.設定内容を確認して作成ボタンをクリックします。

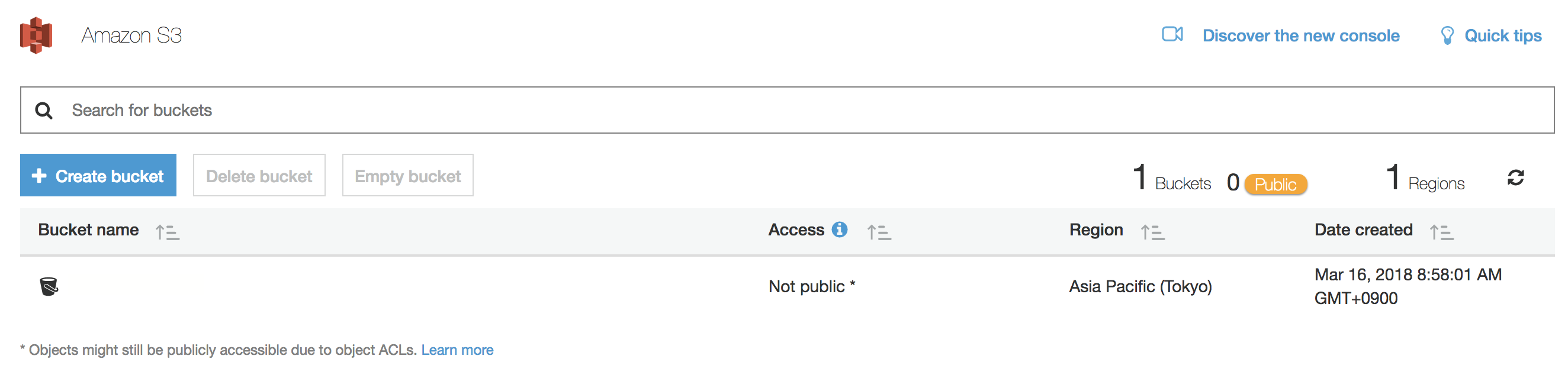

作成されたバケットはダッシュボードに表示されます。

VPCエンドポイントの設定

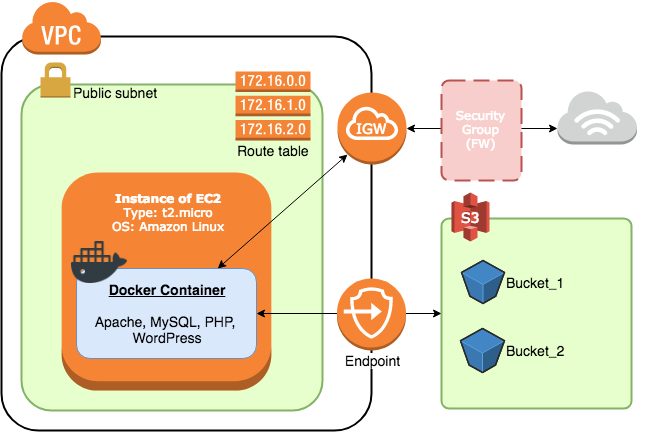

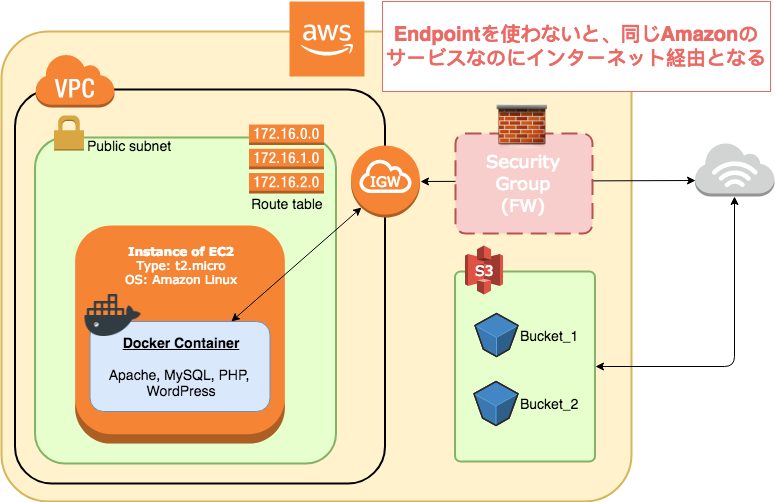

今回はEC2とS3の間でファイルの転送を行いたいのですが、S3はEC2が設置されているネットワーク(VPC)の外側にあるサービスです。

そこで、エンドポイントと呼ばれるコンポーネントをVPCにアタッチして、S3との通信ができるように設定する必要があります。

これまでの記事で構築したインフラにエンドポイントをアタッチすると、次のようなイメージになります。

S3との通信はインターネットゲートウェイ経由でも可能ですが、その場合はトラフィックが一度インターネットへ出てしまいます。VPCエンドポイントを使えば、AWSのサービス内でセキュアにトラフィックを流すことができ、通信料金もかからないので経済的です。

VPCエンドポイントの作り方

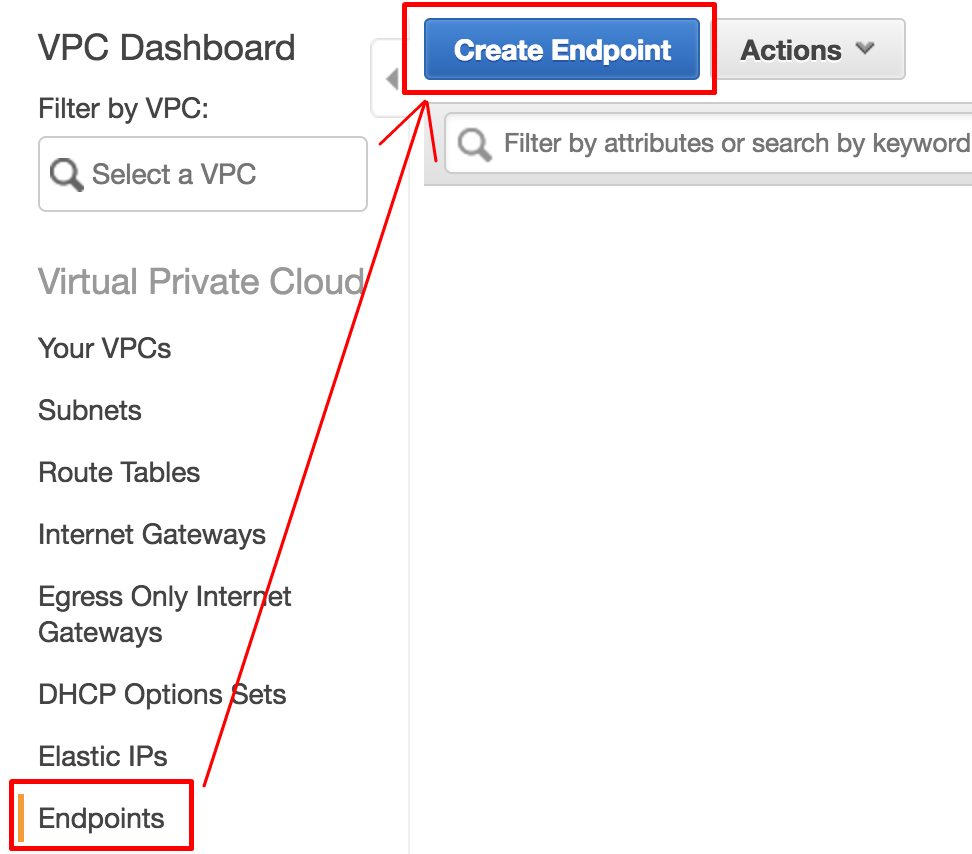

1.VPCのダッシュボードを開き、 エンドポイント の作成ボタンをクリックします。

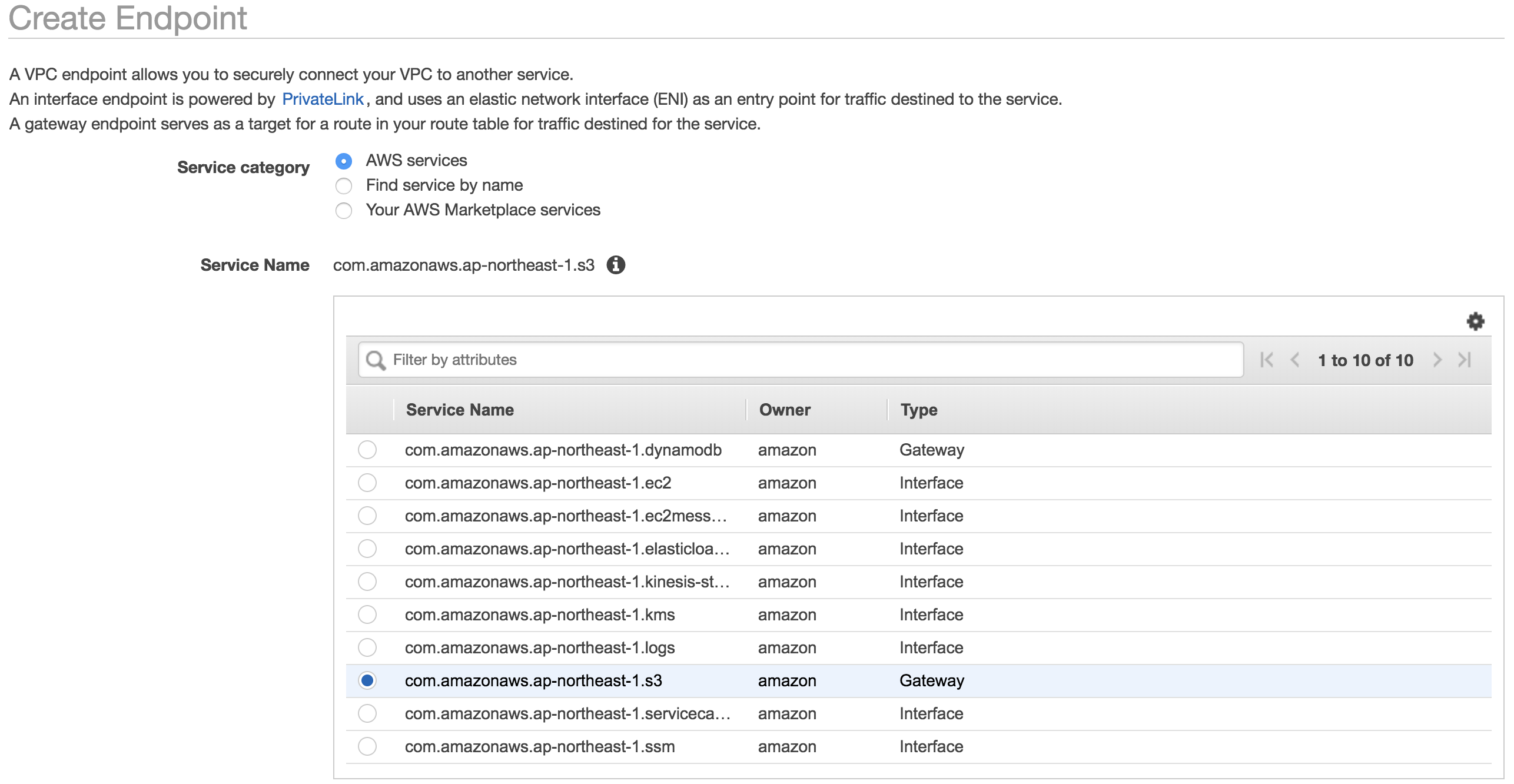

2.宛先の選択をします。 AWS services と com.amazonaws.ap-northeast-1.s3 にチェックを入れます。

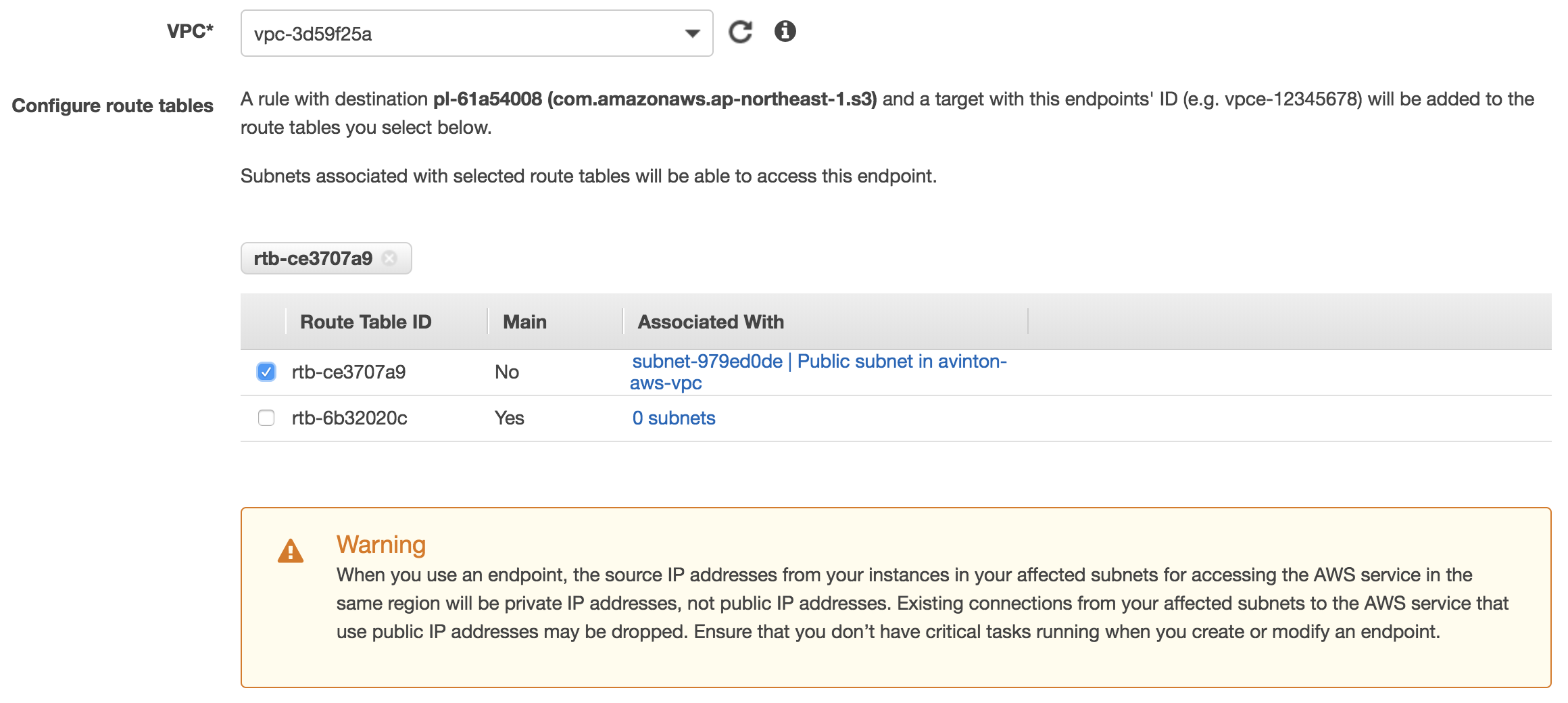

3.通信したいEC2インスタンスが置かれているVPC と そのサブネットに当てられているルートテーブル を選択します。エンドポイント作成時に一度通信が遮断されるので、インスタンスで何か通信を行なっている場合は、それが終わってから作成すると良いでしょう。

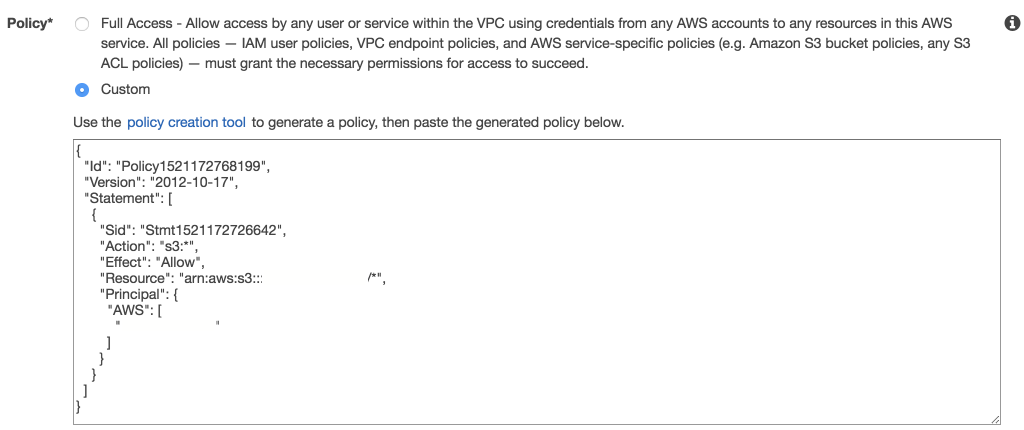

4.ポリシーの設定をします。デフォルトでは全ての操作を許可するポリシーがセットされていますが、このようなポリシーはセキュリティホールの原因となるので、必要最小限のポリシーに絞ります。作成したS3のバケットに対してのみ操作可能なポリシーを作成しましょう。

ポリシーの例:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 |

{ "Version": "2012-10-17", "Id": "Policyxxxxxxxxxxxxx", "Statement": [ { "Sid": "Access-to-S3", "Effect": "Allow", "Principal": "*", "Action": "s3:*", "Resource": [ "arn:aws:s3:::YOUR-S3-BUCKET-NAME", "arn:aws:s3:::YOUR-S3-BUCKET-NAME/*" ] } ] } |

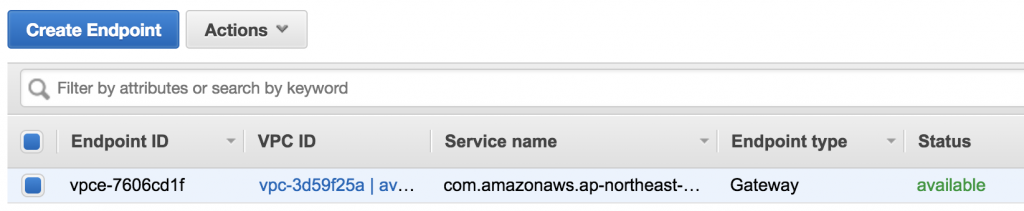

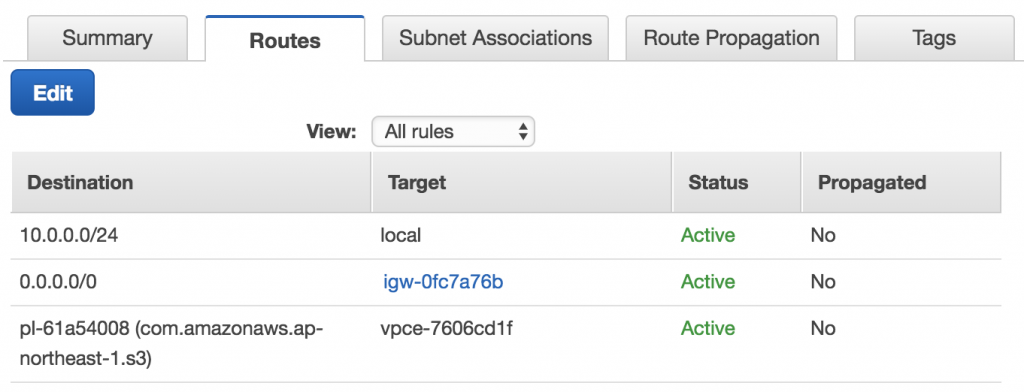

作成が完了すると、ダッシュボードにエンドポイントが表示されます。

紐付けたサブネットのルートテーブルを確認すると、エンドポイントを介したS3への経路が追加されています。

AWS CLIを使ってS3へデータを送信してみる

それではEC2インスタンスからS3のバケットへアクセスできるか見ていきましょう。

インスタンスへsshしてください。

|

1 |

ssh -i "~/.ssh/HOGEHOGE" -p xxxxx USER@FQDN |

~

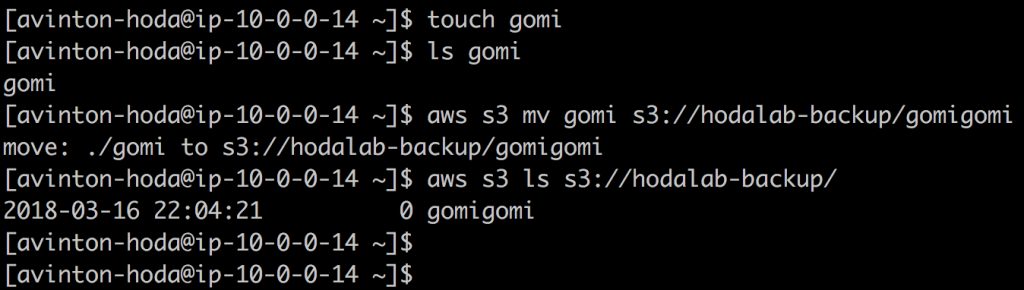

試しにゴミファイルを作成し、バケットへ放り込みます。

|

1 2 3 |

touch gomi aws s3 mv gomi s3://YOUR_S3_BUCKET/gomigomi aws s3 ls s3://YOUR_S3_BUCKET/ |

アップロードできました!やったね!

演習

helpコマンドで aws s3 コマンドを調べてください。どのようなことが出来るでしょうか。気になったコマンドを試してみましょう。

|

1 |

aws s3 help |

まとめ

S3のバケット作成、VPCエンドポイントによるEC2-S3間の経路追加、そしてEC2からバケットへファイルのアップロードを行いました。

次回はAWS CLIとシェルスクリプト、そしてCrontab、3つの技術を駆使してコンテナの自動バックアップシステムを作ります。

>>EC2からS3へ自動でぽいぽいアップロードするスクリプトの作成

あなたも、Avintonでこのような最先端技術を習得し活用してみませんか?

社員の成長を導きながら、AIやビッグデータなどの最先端技術をプロジェクトに活用していくことが私たちのビジョンです。Avintonの充実した技術研修でスキルアップを図り、あなたのキャリア目標を一緒に達成しませんか?